移动端人脸风格化技术的应用

- 信息安全

- 2023-04-02

- 2170

前言

随着元宇宙、数字人、虚拟形象等概念的爆发,各种数字化协同互动的泛娱乐应用也在不断的落地。

例如,在一些游戏中,玩家成为虚拟艺人参与到高还原度的现实艺人日常工作中,并会在特定情况下,与虚拟艺人在人脸表情等层面上形成强映射提升参与感。

而由阿里巴巴天猫推出的超写实数字人AYAYI和井柏然联合“带逛”的杂志《MO Magazine》,则打破传统的平面阅读体验,以虚实结合的形式让读者获得沉浸式体验。

而在这些泛娱乐应用场景中,“人”必然是首要考虑的一步。

而人工设计的数字、动画形象,存在过于“抽象”、代价高昂、缺乏个性化等问题。因此在人脸数字化上,

我们通过研发具有良好控制感、ID感、风格化程度的人脸风格化技术,实现风格定制化的人脸形象切换。

该项技术不仅可以在直播、短视频等娱乐消费场景下作为氛围营造、提高观感的有效手段,

也可在买家秀等图文场景下起到人脸隐私保护、增添乐趣等作用。

更进一步的想象,若不同的用户聚集在某个数字社区内,

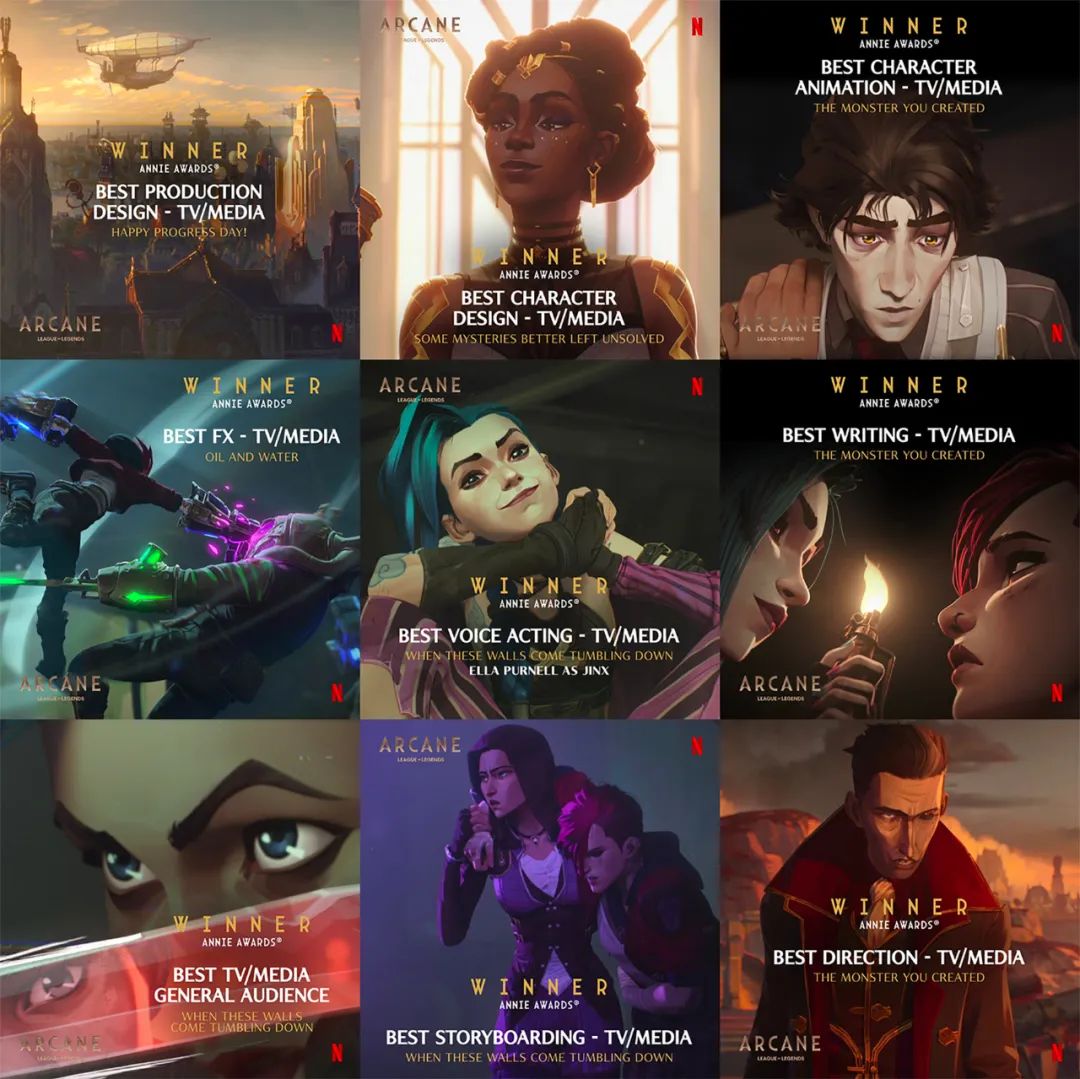

用该社区风格的数字形象聊天社交(例如“双城之战吧”的用户在元宇宙内用双城之战风格化形象友好交流),那是多具有代入感的事情。

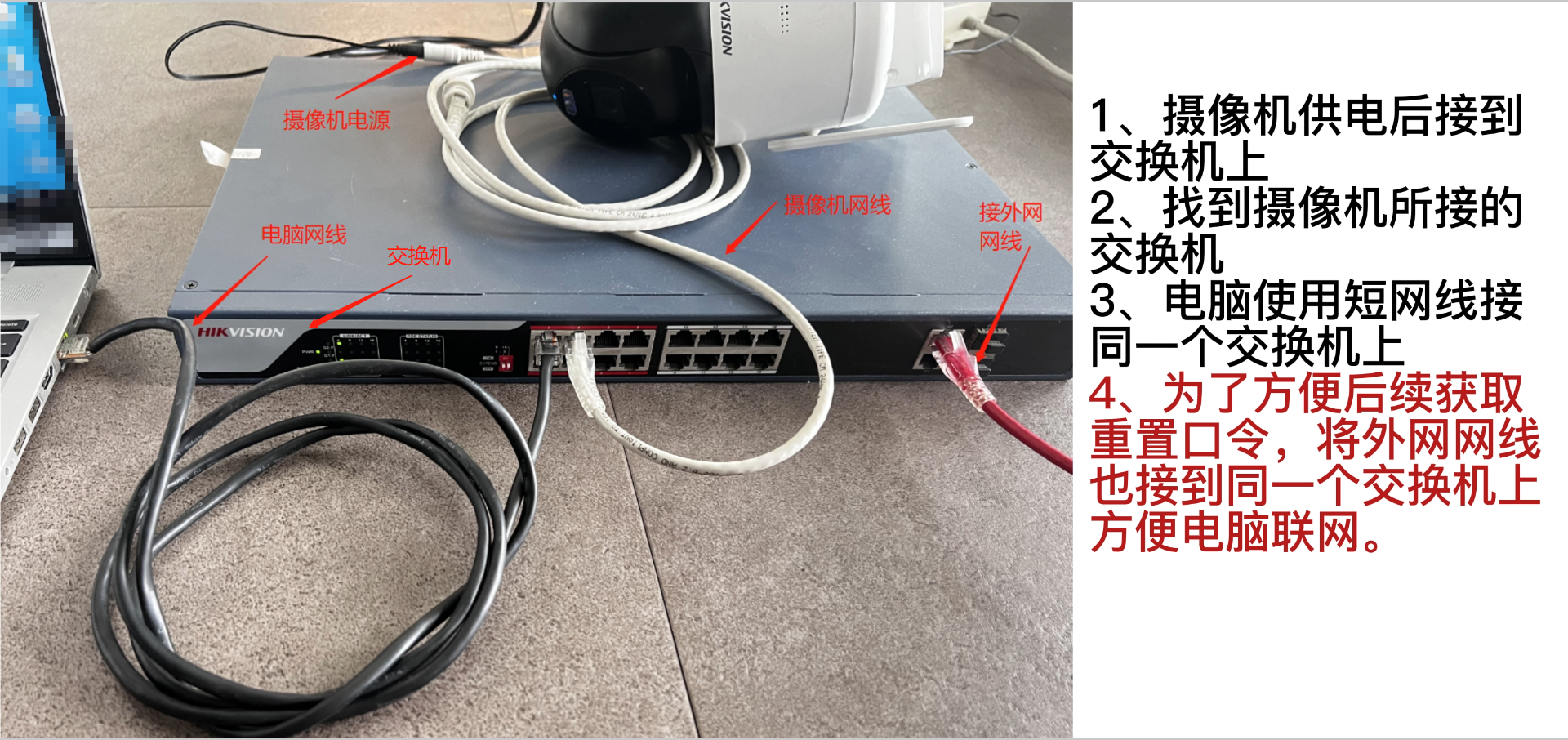

双城之战动画

左图为原始AYAYI的形象,右图为风格化后的形象。

而为了将人脸风格化这项技术落地到我们的直播、买家秀、卖家秀等不同的泛娱乐业务场景,我们做到了:

低成本生产不同人脸风格化编辑的模型(本文所展示的所有效果均在没有任何设计资源的投入下实现的);

适当进行风格编辑以配合设计、产品、运营进行风格选型;

能够在人脸ID感和风格化程度之间做倾斜与平衡;

保证模型的泛化性,以适用于不同的人脸、角度、场景环境;

在保证清晰度等效果的前提下,降低模型对算力的要求。

接下来,我们先看一下demo,然后再介绍我们整个技术流程:感谢我们的产品mm——多菲~

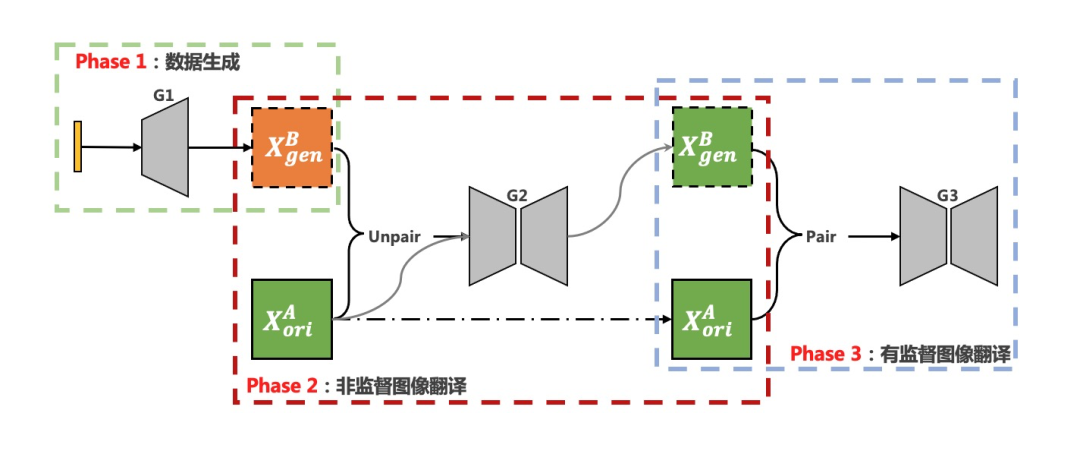

我们的整体算法方案采用三个阶段:

阶段一:基于StyleGAN的风格化数据生成;

阶段二:非监督图像翻译生成配对图像;

阶段三:使用配对图像进行移动端有监督图像翻译模型的训练。

人脸风格化编辑整体算法方案

当然,也可以用二阶段方案:StyleGAN制作pair图像对,然后直接训练有监督小模型。

但增加非监督图像翻译阶段,可以将风格化数据生产和配对图像数据制作两个任务解耦开来,

通过对阶段内算法、阶段间数据的优化改进,结合移动端有监督小模型训练,

最终解决低成本的风格化模型生产、风格的编辑及选型、ID感及风格化的倾斜、部署模型的轻量化等问题。

基于StyleGAN的数据生成

使用StyleGAN算法进行数据生成的工作上,主要针对3个问题的解决:

提升模型的生成数据丰富度和风格化程度:例如生成CG脸更像CG,且各个角度、表情、发型等形象更丰富;

提升数据生成效率:生成的数据良率高、分布更加可控;

风格编辑及选型:例如修改CG脸的眼睛大小。

下面我们针对这三方面展开。

▐ 丰富度和风格化

基于StyleGAN2-ADA的迁移学习遇到的第一个重要问题就是:模型的丰富度和模型的风格化程度之间的trade-off。

使用训练集 进行迁移学习时,受训练集数据的丰富度影响,迁移后的模型在人脸表情、人脸角度、人脸元素等方面的丰富度也会受损;

进行迁移学习时,受训练集数据的丰富度影响,迁移后的模型在人脸表情、人脸角度、人脸元素等方面的丰富度也会受损;

同时,随着迁移训练的迭代代数增加、模型风格化程度/FID的提升,模型丰富度也会越低。

这会使得后续应用模型生成的风格化数据集分布过于单调,不利于U-GAT-IT的训练。

为了提升模型的丰富度,我们进行了如下改进:

调整、优化训练数据集的数据分布;

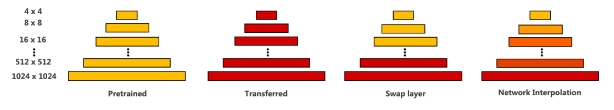

模型融合:因为源模型在大量数据上进行训练,所以源模型的生成空间具有非常高的丰富度;

如果将迁移模型低分辨率层的权重替换为源模型对应层权重得到融合模型,则可使得新模型的生成图像在大的元素/特征上的分布与源模型一致,

从而在低分辨率特征上获得与源模型一致的丰富度;

融合方式:Swap layer直接交换不同层的参数,容易造成生成图像的不协调、细节bad cases;而通过平滑的模型插值,

可以获得更好的生成效果(下面的图示皆由插值融合方式的融合模型生成的)

对不同层的学习率以及特征进行约束、优化调整;

迭代优化:人工筛选新生产的数据,添加到原风格化数据集中以提升丰富度,然后在迭代训练优化直到得到一个能生成较高丰富度、满意风格化程度的模型。

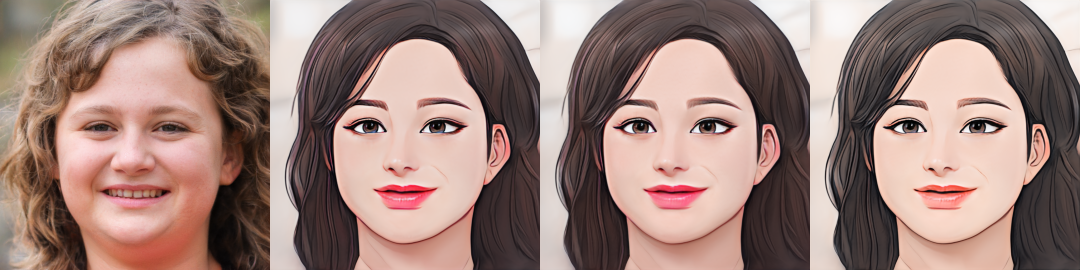

原图,迁移模型,融合模型

▐ 数据生成效率

如果我们拥有一个丰富度高的StyleGAN2模型,那如何生成一个具有丰富分布的风格数据集呢?有两个做法:

随机采样隐变量,生成随机风格数据集;

使用StyleGAN inversion,输入符合一定分布的人脸数据,制作对应的风格数据集。

做法1可以提供更丰富的风格化数据(特别是背景的丰富度),而做法2可以提高生成数据的有效性和提供一定程度的分布控制,提升风格化数据生产效率。

原始图像,StyleGAN Inversion得到的隐向量送入“高级脸风格/动画风格” StyleGAN2生成器得到的图像

▐ 风格编辑及选型

原始风格不太好看是就没法用了

迁移训练后的模型风格就没法改了

No No No,每一个模型不止可以用来生成数据,也可沉淀为一个基础组件、基础能力。

不止是想在原始风格上做微调、优化,甚至是想创造新的风格,都是可以的:

模型融合:通过融合多个模型、设置不同的融合参数/层数、使用不同的融合方式等,可以实现对劣势风格模型做优化,也可实现风格的调整;

模型套娃:将不同风格的模型串联,使得最终输出的风格携带了中间模型的一些五官、色调等风格特征。

融合过程中实现对漫画风格的微调(瞳孔颜色、嘴唇、肤色色调等)

通过风格创造及微调,可以实现不同风格的模型,从而实现不同风格人脸数据的生产。

通过基于StyleGAN的迁移学习、风格编辑优化、数据生成,我们便可以获得我们的第一桶金

本文由H266.VIP于2023-04-02发表在信息视界(H266.VIP),如有疑问,请联系我们。

本文链接:https://h266.vip/post/226.html